十大配资软件公司

十大配资软件公司

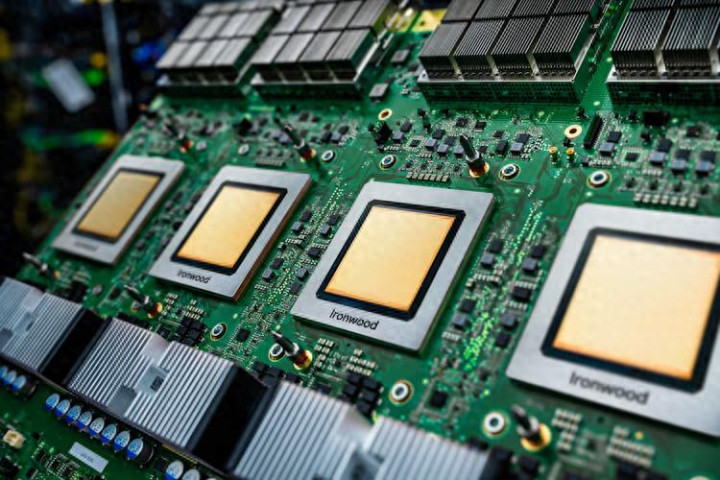

谷歌云正在努力推出其所谓的迄今为止最强大的人工智能基础设施。11月7日谷歌云推出了第七代张量处理单元(TPU) Ironwood和扩展的基于Arm的计算选项,旨在满足对人工智能模型部署的激增需求——该公司将其描述为从训练模型到为数十亿用户服务的推理服务根本性行业转变。

谷歌最新的定制人工智能加速器芯片——TPU 芯片 Ironwood将在未来几周内全面上市。Claude 系列模型背后的人工智能安全公司 Anthropic 披露了获得多达 100 万个此类 TPU 芯片的计划,这是对该技术的惊人验证,该承诺价值数百亿美元,是迄今为止已知最大的人工智能基础设施交易之一。

此举凸显了云提供商之间为控制人工智能驱动的基础设施层而进行的竞争日益的激烈,尽管人们对该行业能否维持当前资本支出速度的质疑越来越大。谷歌的方法——构建定制芯片,而不是仅仅依赖英伟达占主导地位的 GPU 芯片——相当于长期押注,即从芯片设计到软件的垂直整合将提供卓越的经济性和性能。

谷歌云新TPU定位于AI推理服务,而不仅仅是训练

谷歌新TPU定位于“推理时代”,公司将资源从训练前沿人工智能模型转移到将它们部署到每天为数百万或数十亿个请求提供服务的生产应用程序中。

当今的前沿模型,包括谷歌的 Gemini、Veo 和 Imagen 以及 Anthropic 的 Claude,都在TPU张量处理单元上训练和服务。对于许多组织来说,重点正在从训练这些模型转向支持与它们进行有用的、响应迅速的交互。

这种转变对基础设施的要求具有深远的影响。训练工作负载通常可以容忍批处理和较长的完成时间,而推理(实际运行经过训练的模型以生成响应的过程)需要始终如一的低延迟、高吞吐量和坚定不移的可靠性。需要 30 秒才能响应的聊天机器人或经常超时的编码助手,无论底层模型的功能如何,都变得无法使用。

代理工作流程(人工智能系统采取自主行动而不是简单地响应提示)带来了特别复杂的基础设施挑战,需要专门的人工智能加速器和通用计算之间的紧密协调。

Ironwood 的架构内部:9,216 个芯片作为一台超级计算机工作

Ironwood 不仅仅是对谷歌第六代 TPU 的渐进式改进。根据该公司共享的技术规范,与前代产品相比,它在训练和推理工作负载方面提供了4倍多的性能——谷歌将这一优势归因于系统级协同设计方法,而不是简单地增加晶体管数量。

该架构最显着的特点是其规模。单个 Ironwood“吊舱”——一个紧密集成的 TPU 芯片单元,充当一台超级计算机——可以通过谷歌专有的芯片间互连网络连接多达 9,216 个单独的芯片,运行速度为每秒 9.6 太比特。从这个带宽的角度来看,它大致相当于在不到两秒钟的时间内下载整个美国国会图书馆。

这种巨大的互连结构允许 9,216 个芯片共享对 1.77 PB 高带宽内存的访问——内存足够快,可以跟上芯片的处理速度。这大约相当于 40,000 部高清蓝光电影的工作内存,可由数千个处理器同时访问。“就上下文而言,这意味着 Ironwood Pods 可以提供比下一个最接近的竞争对手多 118 倍的 FP8 ExaFLOPS,”谷歌在技术文档中表示。

该系统采用光电路交换技术,充当“动态、可重构结构”。当单个组件出现故障或需要维护时(在这种规模下是不可避免的),OCS 技术会在几毫秒内自动围绕中断重新路由数据流量,从而使工作负载能够继续运行,而不会造成用户可见的中断。

这种可靠性重点反映了部署前五代 TPU 的经验教训。谷歌报告称,自 2020 年以来,其液冷系统全机队正常运行时间保持了约 99.999% 的可用性,相当于每年的停机时间不到六分钟。

Anthropic 的 10 亿美元赌注验证了谷歌的定制芯片战略

也许对 Ironwood 能力最重要的外部验证来自于 Anthropic 对获取多达 100 万个 TPU 芯片的承诺——在一个即使是 10,000 到 50,000 个加速器集群也被认为是巨大的行业中,这是一个惊人的数字。

Anthropic表示:“Anthropic 和谷歌有着长期的合作伙伴关系,这一最新的扩张将帮助我们继续发展定义人工智能前沿所需的计算能力。我们的客户——从财富 500 强公司到人工智能原生初创公司——依靠 Claude 来完成他们最重要的工作,这种扩展的产能确保我们能够满足呈指数级增长的需求。”

根据另一份声明,Anthropic 将获得“到 2026 年上线的容量远远超过千兆瓦”——足以为一个小城市供电。该公司特别将 TPU 的“性价比和效率”列为做出决定的关键因素,以及“使用 TPU 训练和服务其模型的现有经验”。

行业分析师估计,承诺访问 100 万个 TPU 芯片以及相关的基础设施、网络、电源和冷却,可能代表一份价值数百亿美元的多年合同——这是历史上已知最大的云基础设施承诺之一。

Anthropic认为:“Ironwood 在推理性能和训练可扩展性方面的改进将帮助我们高效扩展,同时保持客户期望的速度和可靠性。”

隐藏的挑战:为 1 兆瓦服务器机架供电和冷却

这些发布的背后是谷歌在最近的开放计算项目欧洲、中东和非洲峰会上解决的巨大物理基础设施挑战。该公司透露,它正在实施 +/-400 伏直流电力传输,能够支持每个机架高达 1 兆瓦的电力,比典型部署增加了十倍。

人工智能时代需要更强大的电力传输能力,到 2030 年,ML 将需要每个 IT 机架超过 500 kW。

谷歌正在与 Meta 和 Microsoft 合作,标准化高压直流配电的电气和机械接口。该公司选择 400 VDC 专门用于利用电动汽车建立的供应链,“实现更大的规模经济、更高效的制造以及更高的质量和规模”。

在冷却方面,谷歌透露将把第五代冷却分配单元设计贡献给开放计算项目。该公司“在过去7年中在 2,000 多个 TPU Pod 上部署了千兆瓦规模的液体冷却”,整个机队的可用性约为 99.999%。

在给定的温度变化下,水每单位体积输送的热量大约是空气的 4,000 倍——这在单个 AI 加速器芯片的耗散功率越来越大 1,000 瓦或更多时至关重要。

TPU挑战英伟达的 AI 加速器主导地位

谷歌发布公告之际,人工智能基础设施市场正处于拐点。虽然 Nvidia 在 AI 加速器领域保持着压倒性的主导地位——估计占据 80-95% 的市场份额——但云提供商越来越多地投资定制芯片,以区分其产品并提高单位经济效益。

亚马逊云科技通过基于 Graviton Arm 的 CPU 和 Inferentia / Trainium AI 芯片率先采用了这种方法。Microsoft 已经开发了 Cobalt 处理器,据报道正在开发 AI 加速器。谷歌现在提供主要云提供商中最全面的定制芯片产品组合。

该战略面临固有挑战。定制芯片开发需要巨大的前期投资——通常数十亿美元。专业加速器的软件生态系统落后于 Nvidia 的 CUDA 平台,后者受益于 15+ 年的开发人员工具。人工智能模型架构的快速发展带来了风险,即随着新技术的出现,针对当今模型优化的定制芯片变得不那么重要。

然而,谷歌认为其方法具有独特的优势。“这就是我们十年前构建第一个 TPU 的方式,这反过来又解锁了八年前 Transformer 的发明——正是为大多数现代人工智能提供动力的架构,”该公司指出,他指的是谷歌研究人员在 2017 年发表的开创性论文“注意力就是你所需要的”。

论点是,紧密集成——“模型研究、软件和硬件开发在一个屋檐下”——使得使用现成组件无法实现的优化成为可能。

除了 Anthropic 之外,其他几位客户也提供了早期反馈。开发创意人工智能工具的 Lightricks 报告称,早期的 Ironwood 测试“让我们非常热衷于”为我们的数百万全球客户创建“更细致、更精确、更高保真度的图像和视频生成”,该公司研究总监 Yoav HaCohen 说。

谷歌的公告提出了将在未来几个季度出现的问题。该行业能否维持当前的基础设施支出,主要人工智能公司集体投入数千亿美元?定制芯片在经济上会优于 Nvidia GPU 吗?模型架构将如何发展?

目前,谷歌似乎致力于几十年来定义该公司的战略:构建自定义基础设施以实现在商用硬件上不可能实现的应用程序,然后将该基础设施提供给希望在没有资本投资的情况下具有类似功能的客户。

随着人工智能行业从研究实验室过渡到为数十亿用户提供服务的生产部署,基础设施层——使这一切运行的芯片、软件、网络、电源和冷却——可能与模型本身一样重要。

如果 Anthropic 愿意承诺获得多达 100 万个芯片有任何迹象的话十大配资软件公司,那么谷歌对专为推理时代设计的定制芯片的押注可能会在需求达到拐点时得到回报。

富灯网提示:文章来自网络,不代表本站观点。